doi: 10.56294/ai202222

REVISIÓN

Medical Ethics in Terminal Patients: Dilemmas in the Use of AI for End-of-Life Decisions

Ética médica en pacientes terminales: Dilemas en el uso de IA para decisiones de fin de vida

Ana María Chaves Cano1 ![]() *

*

1Fundación Universitaria Juan N. Corpas. Bogotá, Colombia.

Citar como: Chaves Cano AM. Medical Ethics in Terminal Patients: Dilemmas in the Use of AI for End-of-Life Decisions. EthAIca. 2022; 1:22. https://doi.org/10.56294/ai202222

Enviado: 17-01-2022 Revisado: 28-03-2022 Aceptado: 15-05-2022 Publicado: 16-05-2022

Editor: PhD.

Rubén González Vallejo ![]()

Autor para la correspondencia: Ana María Chaves Cano *

ABSTRACT

Medical ethics in terminal patients faces unprecedented challenges with the integration of artificial intelligence (AI) in end-of-life decision-making. This article aims to analyze the ethical dilemmas arising from the use of AI in this context by exploring its implications for autonomy, dignity, and the humanization of palliative care. To this end, a literature review was conducted of articles in Spanish and English indexed in Scopus between 2018 and 2022, selecting studies that addressed the intersection of AI, bioethics, and palliative medicine. The results were organized into four thematic axes: patient autonomy and informed consent, algorithmic biases and equity in recommendations, dehumanization versus optimization of care, and legal and moral responsibility in automated decisions. It was identified that, although AI can improve the accuracy of forecasts and treatments, its implementation requires ethical safeguards to prevent the reduction of the doctor-patient relationship to a technical process. The conclusions highlight the need for regulatory frameworks that balance technological innovation with bioethical principles, prioritizing human dignity and the active participation of patients and families in end-of-life decisions.

Keywords: Medical Ethics; Artificial Intelligence; Palliative Care; Patient Autonomy; End-of-Life Decisions.

RESUMEN

La ética médica en pacientes terminales enfrenta desafíos sin precedentes con la integración de la inteligencia artificial (IA) en la toma de decisiones de fin de vida. Este artículo tiene como objetivo analizar los dilemas éticos derivados del uso de IA en este contexto, al explorar sus implicaciones en la autonomía, dignidad y humanización del cuidado paliativo. Para ello, se realizó una revisión documental de artículos en español e inglés indexados en Scopus entre 2018 y 2022, se seleccionaron estudios que abordaran la intersección entre IA, bioética y medicina paliativa. Los resultados se organizaron en cuatro ejes temáticos: autonomía del paciente y consentimiento informado, sesgos algorítmicos y equidad en las recomendaciones, deshumanización versus optimización de cuidados, y responsabilidad legal y moral en decisiones automatizadas. Se identificó que,aunque la IA puede mejorar la precisión en pronósticos y tratamientos, su implementación requiere salvaguardas éticas para evitar la reducción de la relación médico-paciente a un proceso técnico. Las conclusiones destacan la necesidad de marcos regulatorios que equilibren innovación tecnológica con principios bioéticos, al priorizar la dignidad humana y la participación activa de pacientes y familias en las decisiones de fin de vida.

Palabras clave: Ética Médica, Inteligencia Artificial, Cuidados Paliativos, Autonomía Del Paciente, Decisiones de Fin de Vida.

INTRODUCCIÓN

La medicina paliativa y el manejo de pacientes terminales representan uno de los campos más sensibles de la práctica clínica.(1,2) Tradicionalmente, estas decisiones han sido guiadas por principios bioéticos como la autonomía, la beneficencia, la no maleficencia y la justicia.(3) Sin embargo, el avance de la inteligencia artificial (IA) en el ámbito sanitario introduce nuevas complejidades, especialmente cuando algoritmos predictivos o sistemas de apoyo a la decisión clínica intervienen en escenarios de fin de vida.(4,5)

La IA promete optimizar procesos diagnósticos y pronósticos en pacientes terminales, al ofrecer predicciones más precisas sobre supervivencia o respuestas a tratamientos.(6,7) No obstante, su aplicación en este contexto plantea dilemas éticos fundamentales.(8) Según Gómez-Cano,(9) la automatización de decisiones críticas podría erosionar la relación médico-paciente, al reducir un momento profundamente humano a un cálculo probabilístico. Además, los sesgos intrínsecos en los datos de entrenamiento de estos sistemas amenazan con perpetuar inequidades en el acceso a cuidados paliativos de calidad.(10,11)

Otro desafío central radica en la tensión entre eficiencia técnica y humanización.(12) Mientras la IA puede agilizar protocolos o identificar opciones terapéuticas, su uso excesivo podría desplazar elementos esenciales del cuidado paliativo, como la empatía, la escucha activa y la adaptación a las preferencias individuales.(13,14) Estudios realizados por Areia(15) y Zeng(16) alertan sobre el riesgo de que los profesionales de la salud deleguen en la tecnología decisiones que requieren sensibilidad moral, especialmente en culturas donde la muerte sigue siendo un tabú y las familias demandan un trato personalizado.

La responsabilidad legal y moral en el uso de IA para decisiones de fin de vida también es un terreno inexplorado.(6,9) La opacidad de muchos sistemas de IA dificulta evaluar si sus conclusiones se ajustan a estándares éticos, lo que exige mecanismos de transparencia y rendición de cuentas.(1,14) A esto se suma la vulnerabilidad de los pacientes terminales, cuya capacidad para consentir o cuestionar recomendaciones automatizadas puede estar comprometida por su condición clínica.(17)

Este artículo surge ante la urgente necesidad de analizar críticamente estos dilemas, en un momento donde la IA avanza sin que los marcos éticos y legales evolucionen a la misma velocidad. Su objetivo es examinar los desafíos éticos del uso de IA en decisiones de fin de vida, a través de una revisión documental que identifique tanto los riesgos como las oportunidades para preservar la dignidad humana en el cuidado de pacientes terminales. Al hacerlo, se busca contribuir al debate sobre cómo integrar la tecnología en la medicina paliativa sin sacrificar sus fundamentos humanistas.

MÉTODO

El presente estudio se basa en una revisión documental sistemática de la literatura científica sobre los dilemas éticos en el uso de IA para la toma de decisiones en pacientes terminales. Este enfoque permite sintetizar el conocimiento existente, identificar tendencias y analizar críticamente los debates éticos en este campo emergente. La revisión se realizó siguiendo un protocolo estructurado que garantizó rigurosidad en la selección, evaluación y análisis de las fuentes, con el fin de ofrecer una perspectiva integral sobre el tema.(18) La revisión se efectuó en etapas previamente definidas que añadieron rigurosidad científica y robustez al proceso de búsqueda y selección de información.

Definición de los criterios de búsqueda

Se establecieron palabras clave en español e inglés relacionadas con ética médica, IA, cuidados paliativos y decisiones de fin de vida. La búsqueda se limitó a artículos publicados entre 2018 y 2022 en la base de datos Scopus, seleccionada por su amplia cobertura de literatura científica en ciencias de la salud y bioética.

Recolección y selección inicial de documentos

Se aplicaron filtros para incluir únicamente artículos revisados por pares, capítulos de libros y revisiones sistemáticas. Tras una primera revisión de títulos y resúmenes, se descartaron aquellas publicaciones que no abordaban directamente la intersección entre IA y ética en pacientes terminales.

Evaluación de la calidad y relevancia

Los documentos preseleccionados fueron analizados en profundidad para determinar su pertinencia teórica y metodológica. Se priorizaron estudios que presentaran evidencia empírica, marcos conceptuales sólidos o discusiones éticas fundamentadas.

Extracción y categorización de la información

Los datos relevantes se organizaron en torno a cuatro ejes temáticos predefinidos: autonomía del paciente, sesgos algorítmicos, humanización del cuidado y responsabilidad legal. Esta clasificación permitió un análisis comparativo de las posturas éticas identificadas en la literatura.

Síntesis y análisis crítico

Finalmente, se integraron los hallazgos para construir una discusión coherente. De esta forma se logró constatar perspectivas y destacar consensos y controversias en el campo.

Este enfoque metodológico garantizó una revisión exhaustiva y fundamentada, lo que facilitó la identificación de vacíos en la literatura y proyecciones futuras sobre el uso ético de la IA en medicina paliativa.(19,20) La sistematización del proceso, desde la búsqueda hasta el análisis, contribuyó a minimizar sesgos y asegurar la validez de las conclusiones obtenidas.

RESULTADOS

El análisis de la literatura permitió identificar que la incorporación de la inteligencia artificial en la toma de decisiones de fin de vida genera tensiones éticas profundas, particularmente en torno a la preservación de la dignidad humana, la autonomía del paciente y la equidad en el acceso a cuidados paliativos. Si bien la IA ofrece herramientas valiosas para mejorar la precisión diagnóstica y pronóstica, su implementación en contextos terminales exige una refleión crítica sobre sus implicaciones morales y prácticas. Los hallazgos se organizaron en cuatro ejes temáticos, que abarcan desde los desafíos en el consentimiento informado hasta los riesgos de deshumanización en el cuidado paliativo. A continuación, se desarrolla cada uno de estos ejes, al integrar perspectivas teóricas y debates actuales en el campo de la bioética y la medicina.

Autonomía del paciente y consentimiento informado

El principio de autonomía, fundamental en la ética médica, enfrenta nuevos desafíos al ser influenciadas las decisiones clínicas por sistemas de IA.(21) En pacientes terminales, donde la capacidad de decisión puede estar comprometida por el deterioro físico o cognitivo, la transparencia en el funcionamiento de los algoritmos se vuelve crítica.(12,22) Sin embargo, muchos modelos de IA operan como "cajas negras", lo que dificulta que médicos, pacientes y familias comprendan cómo se generan las recomendaciones (ver figura 1).(23)

Figura 1. Requisitos de la ética médica en IA

Por otro lado, el consentimiento informado en este contexto exige no solo explicar los beneficios y riesgos de un tratamiento, sino también el papel que juega la IA en su selección.(24) Shlobin(25) señala que, en muchos casos, los pacientes desconocen que sus planes de cuidado paliativo han sido guiados por algoritmos, lo que cuestiona la validez ética de su aceptación. Además, la complejidad técnica de estos sistemas puede generar una brecha de comprensión, donde el profesional de la salud actúa como intermediario sin dominar plenamente los fundamentos de la IA.(26)

La literatura también discute si la IA podría fortalecer la autonomía al proporcionar pronósticos más precisos que permitan al paciente tomar decisiones mejor informadas.(27) No obstante, esto depende de que los sistemas estén diseñados para priorizar la interpretabilidad y que los equipos médicos reciban formación en comunicación ética de tecnologías emergentes.(28)

Un debate adicional gira en torno a la vulnerabilidad aumentada de los pacientes terminales.(9,22) Su dependencia emocional y física los hace más susceptibles a aceptar recomendaciones automatizadas sin cuestionarlas, especialmente en sistemas de salud con limitaciones de tiempo y recursos humanos.(29) Esto exige protocolos que aseguren la participación activa del paciente y su familia en las decisiones mediadas por IA.(30,31)

Sesgos algorítmicos y equidad en las recomendaciones

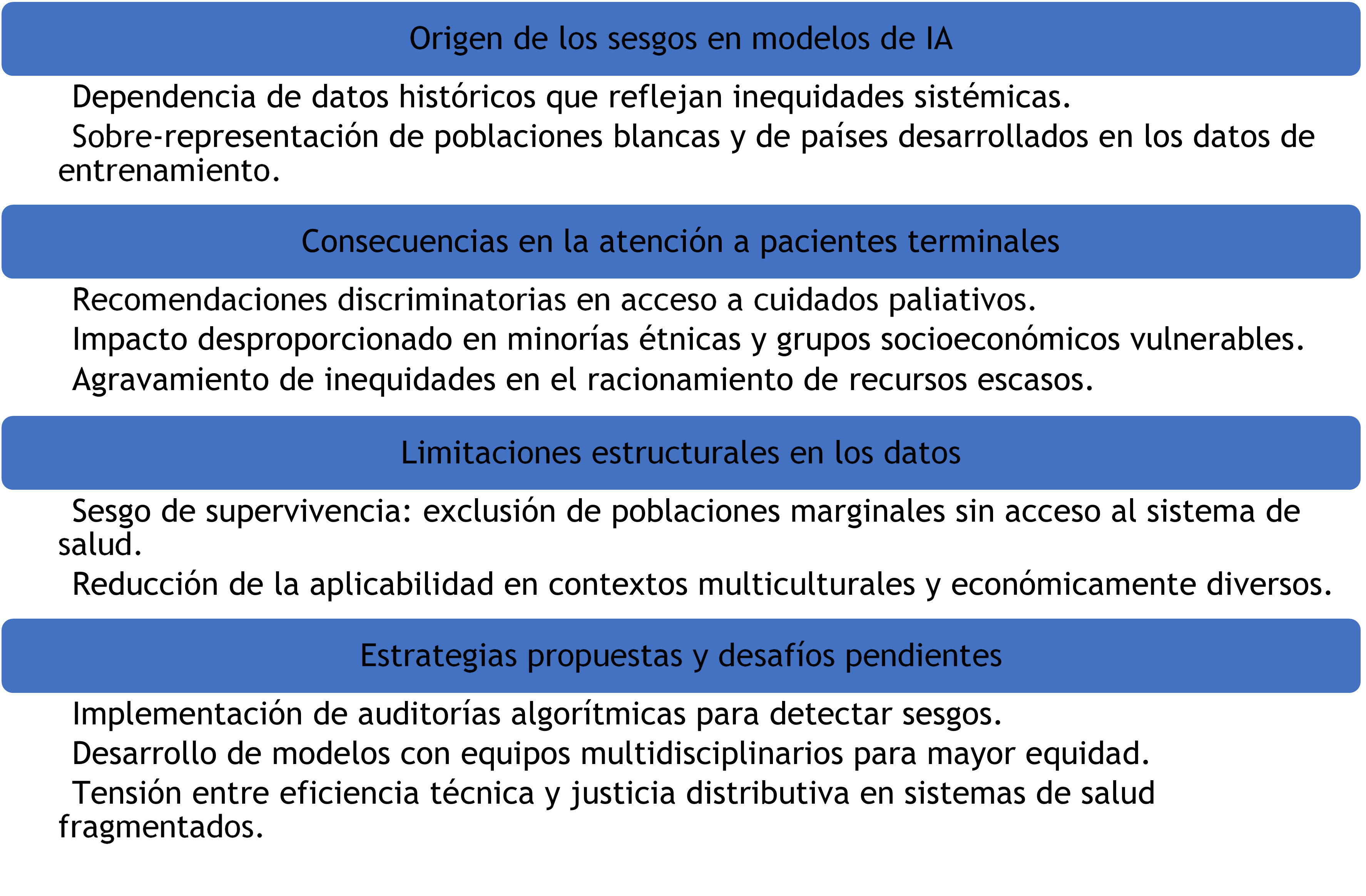

La dependencia de la IA en datos históricos para entrenar sus modelos introduce riesgos de sesgos sistémicos que pueden perpetuar inequidades en el cuidado de pacientes terminales (ver figura 2).(12) Convie y otros autores(32) muestran que algoritmos utilizados en pronósticos de supervivencia suelen estar basados en poblaciones mayoritariamente blancas y de países desarrollados, lo que reduce su precisión en grupos minoritarios o con menos acceso a salud.

Figura 2. Origen y riesgos asociados a los sesgos algorítmicos

Estos sesgos pueden traducirse en recomendaciones discriminatorias, como subestimar la necesidad de cuidados paliativos en pacientes de ciertas etnias o condiciones socioeconómicas.(33) Este problema se agrava en contextos donde la IA se emplea para racionar servicios escasos, como camas de cuidados intensivos o terapias costosas.(34)

La literatura también alerta sobre el "sesgo de supervivencia", los datos disponibles suelen provenir de pacientes que han accedido al sistema de salud, lo que excluye a aquellos en situaciones de marginalidad.(35) Esto limita, en opinión del autor, la capacidad de la IA para ofrecer soluciones equitativas en entornos con diversidad cultural y económica.

Frente a esto, se proponen estrategias como la auditoría algorítmica y la inclusión de equipos multidisciplinarios en el desarrollo de estas herramientas.(36) Sin embargo, persiste el desafío de equilibrar la eficiencia técnica con la justicia distributiva, especialmente en sistemas de salud fragmentados.

Deshumanización versus optimización de cuidados

El uso de IA en la atención a pacientes terminales plantea una paradoja fundamental, mientras puede optimizar aspectos técnicos del cuidado paliativo, también amenaza con despersonalizar la relación médico-paciente.(37) La literatura revisada destaca que la medicina paliativa se fundamenta en dimensiones humanistas que los algoritmos no pueden replicar.(27) Estudios cualitativos revelan que pacientes y familias perciben la IA como un elemento frío al sustituir interacciones clínicas significativas, especialmente en momentos de alta carga emocional.(30,38)

No obstante, algunos autores argumentan que la IA podría liberar tiempo para el cuidado humanizado, al automatizar tareas administrativas o diagnósticas rutinarias.(39) Sin embargo, esta potencialidad depende de que los sistemas de salud prioricen modelos asistenciales centrados en la persona, en lugar de reducir costos mediante la automatización indiscriminada.(33,34)

Un riesgo crítico identificado es la ilusión de objetividad.(40) Al confiar en recomendaciones algorítmicas percibidas como "libres de emociones", los profesionales podrían subvalorar aspectos contextuales cruciales en decisiones de fin de vida.(41) Casos documentados muestran cómo algoritmos han recomendado suspender tratamientos sin considerar el valor simbólico que estos tenían para familias en procesos de duelo.(42)

La literatura también explora el rol de la IA en la comunicación de malas noticias.(8,15,38) Aunque chatbots o avatares virtuales han sido probados para informar diagnósticos terminales, su uso genera controversia.(43) Mientras algunos defienden su precisión en la transmisión de información clínica, otros subrayan que la presencia humana es insustituible para contener el sufrimiento.(44)

En opinión del autor, la IA debe integrarse como herramienta de apoyo, nunca como sustituto del juicio clínico ético. Se requieren protocolos que delimiten sus aplicaciones, para garantizar que la tecnología no eclipse la dimensión humana del cuidado paliativo.

Responsabilidad legal y moral en decisiones automatizadas

La imputabilidad de las decisiones mediadas por IA en contextos terminales constituye un vacío legal y ético.(28,33) Al recomendar un algoritmo una acción que lleva a la muerte prematura de un paciente, la cadena de responsabilidad se diluye entre desarrolladores, instituciones médicas y profesionales.(45) La revisión identificó que los marcos regulatorios actuales no abordan adecuadamente este problema, al dejar a los médicos en una posición de vulnerabilidad jurídica (ver figura 3)(46) seguido recomendaciones algorítmicas contra sus convicciones, por temor a demandas.(49)

Figura 3. Desafíos Éticos y Legales en Decisiones Médicas Mediadas por IA

Un debate central gira en torno a la opacidad de los algoritmos propietarios. Empresas tecnológicas suelen proteger sus modelos como secretos comerciales, lo que imposibilita evaluar si una recomendación se basó en evidencia sólida o en datos sesgados.(47) Esto contradice principios bioéticos de transparencia y rendición de cuentas, especialmente críticos mientras las decisiones afectan la vida o muerte.(37)

La literatura también analiza conflictos en la ética de las virtudes. Mientras la medicina paliativa tradicional valora la prudencia y la compasión, la IA opera bajo lógicas de eficiencia y probabilidad.(34,39) Este choque puede llevar a que médicos prioricen cumplir con protocolos automatizados sobre su propio criterio moral.(48)

DISCUSIÓN

Los hallazgos de esta revisión revelan una tensión fundamental entre la capacidad de la inteligencia artificial para optimizar procesos médicos y su potencial para erosionar aspectos esenciales de la atención paliativa. Mientras los sistemas basados en IA pueden mejorar la precisión pronóstica y estandarizar protocolos, su implementación sin salvaguardas éticas adecuadas amenaza con transformar decisiones profundamente humanas en ejercicios técnicos despersonalizados.(50, 51) Esta paradoja es particularmente crítica en el contexto de pacientes terminales, donde la calidad de la atención se mide no solo por resultados clínicos, sino por la preservación de la dignidad y el respeto a las preferencias individuales.(15,18)

Un hallazgo preocupante es la forma en que los sesgos inherentes a los datos de entrenamiento pueden perpetuar desigualdades en el acceso a cuidados paliativos de calidad. La literatura evidencia cómo algoritmos desarrollados con poblaciones mayoritarias frecuentemente fallan al atender las necesidades de grupos minoritarios o marginados, lo que exige mecanismos de auditoría más rigurosos.(45,52) Además, la opacidad de muchos sistemas comerciales dificulta evaluar si sus recomendaciones se ajustan a principios de equidad, lo que plantea serios desafíos para la justicia distributiva en salud.(39)

El análisis también destaca cómo la creciente dependencia de herramientas algorítmicas podría alterar la naturaleza misma de la relación clínica en contextos terminales. Existe el riesgo de que los profesionales médicos, ante la presión por adoptar tecnologías emergentes, deleguen en los sistemas de IA juicios que requieren sensibilidad moral y comprensión contextual.(32,41) Esto es especialmente problemático debido a que las recomendaciones automatizadas no consideran dimensiones culturales, espirituales o emocionales que son centrales para pacientes y familias en procesos de fin de vida.(44,53)

Finalmente, la revisión identifica una urgente necesidad de desarrollar marcos regulatorios específicos que aborden las particularidades éticas del uso de IA en medicina paliativa. Estos deben equilibrar la innovación tecnológica con la protección de valores fundamentales, estableciendo claramente límites a la automatización de decisiones críticas y mecanismos de transparencia algorítmica.(52,54) El desafío consiste en aprovechar las ventajas de la IA sin sacrificar los principios humanistas que han guiado tradicionalmente el cuidado de pacientes terminales, para mantener siempre al ser humano en el centro del proceso asistencial.(55)

CONCLUSIONES

El análisis evidencia que la implementación de IA en la toma de decisiones para pacientes terminales requiere un equilibrio delicado entre innovación tecnológica y preservación de los principios éticos fundamentales. Si bien estos sistemas pueden optimizar aspectos técnicos del cuidado paliativo, su uso debe estar estrictamente regulado para garantizar la autonomía del paciente, evitar sesgos algorítmicos, mantener la humanización de la atención y clarificar las responsabilidades legales y morales. Se concluye que la IA debe funcionar como herramienta de apoyo -nunca como sustituto- del juicio clínico y los valores humanistas que deben guiar el acompañamiento en el final de la vida, requiriéndose marcos éticos específicos y formación profesional para su uso responsable.

La investigación revela la necesidad urgente de desarrollar protocolos que prioricen la transparencia algorítmica, la equidad en el acceso y la participación activa de pacientes y familias, para asegurar que la tecnología sirva para mejorar -no erosionar- la calidad del cuidado paliativo centrado en la persona. Futuros estudios deberían explorar las percepciones de los propios pacientes terminales sobre estas tecnologías, un aspecto crítico hasta ahora poco investigado.

CONCLUSIONES

El análisis evidencia que la implementación de IA en la toma de decisiones para pacientes terminales requiere un equilibrio delicado entre innovación tecnológica y preservación de los principios éticos fundamentales. Si bien estos sistemas pueden optimizar aspectos técnicos del cuidado paliativo, su uso debe estar estrictamente regulado para garantizar la autonomía del paciente, evitar sesgos algorítmicos, mantener la humanización de la atención y clarificar las responsabilidades legales y morales. Se concluye que la IA debe funcionar como herramienta de apoyo -nunca como sustituto- del juicio clínico y los valores humanistas que deben guiar el acompañamiento en el final de la vida, requiriéndose marcos éticos específicos y formación profesional para su uso responsable.

La investigación revela la necesidad urgente de desarrollar protocolos que prioricen la transparencia algorítmica, la equidad en el acceso y la participación activa de pacientes y familias, para asegurar que la tecnología sirva para mejorar -no erosionar- la calidad del cuidado paliativo centrado en la persona. Futuros estudios deberían explorar las percepciones de los propios pacientes terminales sobre estas tecnologías, un aspecto crítico hasta ahora poco investigado.

REFERENCIAS BIBLIOGRÁFICAS

1. Garetto F, Cancelli F, Rossi R, Maltoni M. Palliative Sedation for the Terminally Ill Patient. CNS Drugs 2018;32(10):951-961. https://doi.org/10.1007/s40263-018-0576-7

2. Tatum P, Mills S. Hospice and Palliative Care: An Overview. Medical Clinics of North America 2020;104(3):359-373. https://doi.org/10.1016/j.mcna.2020.01.001

3. Rosenberg L, Fishel A, Harley R, Stern T, Emanuel L, Cohen J. Psychological Dimensions of Palliative Care Consultation: Approaches to Seriously Ill Patients at the End of Life. Journal of Clinical Psychiatry 2022;83(2):22ct14391. https://doi.org/10.4088/JCP.22ct14391

4. Gómez Cano CM, Valencia Arias JA. Mechanisms used to measure technological innovation capabilities in organizations: results from a bibliometric analysis. Revista Guillermo de Ockham 2020;18(1):69-79. https://doi.org/10.21500/22563202.4550

5. Quinn K, Wegier P, Stukel T, Huang A, Bell C, Tanuseputro P. Comparison of Palliative Care Delivery in the Last Year of Life Between Adults With Terminal Noncancer Illness or Cancer. JAMA Network Open 2021;4(3):e210677. https://doi.org/10.1001/jamanetworkopen.2021.0677

6. Heydari H, Hojjat-Assari S, Almasian M, Pirjani P. Exploring health care providers’ perceptions about home-based palliative care in terminally ill cancer patients. BMC Palliative Care 2019;18:66. https://doi.org/10.1186/s12904-019-0452-3

7. Gómez CA, Sánchez V, Fajardo MY. Projects and their dimensions: a conceptual approach. Contexto 2018;7:57-64. http://contexto.ugca.edu.co

8. Anandarajah G, Mennillo H, Rachu G, Harder T, Ghosh J. Lifestyle Medicine Interventions in Patients With Advanced Disease Receiving Palliative or Hospice Care. American Journal of Lifestyle Medicine 2019;14(3):243-257. https://doi.org/10.1177/1559827619830049

9. Gómez-Cano C, Sánchez V, Tovar G. Endogenous factors causing irregular permanence: a reading from teaching practice. Educación y Humanismo 2018;20(35):96-112. http://dx.10.17081/eduhum.20.35.3030

10. Coeckelbergh M. AI for climate: freedom, justice, and other ethical and political challenges. AI and Ethics 2020;1(1):67-72. https://doi.org/10.1007/s43681-020-00007-2

11. Simon S, Pralong A, Radbruch L, Bausewein C, Voltz R. The Palliative Care of Patients With Incurable Cancer. Deutsches Ärzteblatt International 2020;116(7):108-115. https://doi.org/10.3238/arztebl.2020.0108

12. Frasca M, Galvin A, Raherison C, Soubeyran P, Burucoa B, Bellera C, Mathoulin-Pélissier S. Palliative versus hospice care in patients with cancer: a systematic review. BMJ Supportive & Palliative Care 2020;11(2):188-199. https://doi.org/10.1136/bmjspcare-2020-002195

13. Kim C, Kim S, Lee K, Choi J, Kim S. Palliative Care for Patients With Heart Failure. Journal of Hospice and Palliative Nursing 2022;24(3):E151-E158. https://doi.org/10.1097/NJH.0000000000000869

14. Gómez-Monroy CA, Cuesta-Ramírez DH, Gómez-Cano CA. Analysis of the perception of tax on the consumption of plastic bags charged in large and medium-sized establishments from the center of Florence. LOGINN Investigación Científica y Tecnológica 2021;5(1). https://dx.doi.org/10.23850/25907441.4320

15. Areia N, Gongóra J, Major S, Oliveira V, Relvas A. Support interventions for families of people with terminal cancer in palliative care. Palliative and Supportive Care 2020;18(5):580-588. https://doi.org/10.1017/S1478951520000127

16. Zeng Y, Wang C, Ward K, Hume A. Complementary and Alternative Medicine in Hospice and Palliative Care: A Systematic Review. Journal of Pain and Symptom Management 2018;56(5):781-794.e4. https://doi.org/10.1016/j.jpainsymman.2018.07.016

17. Strang P. Palliative oncology and palliative care. Molecular Oncology 2022;16(19):3399-3409. https://doi.org/10.1002/1878-0261.13278

18. Guayara Cuéllar CT, Millán Rojas EE, Gómez Cano CA. Design of a virtual digital literacy course for teachers at the University of Amazonia. Revista Científica 2019;(34):34-48. https://doi.org/10.14483/23448350.13314

19. Hui D, Bruera E. Models of Palliative Care Delivery for Patients With Cancer. Journal of Clinical Oncology 2020;38(9):852-865. https://doi.org/10.1200/JCO.18.02123

20. Rigue A, Monteiro D. Difficulties of nursing professionals in the care management of cancer patients in palliative care. Research, Society and Development 2020;9(10):e9109073. https://doi.org/10.33448/rsd-v9i10.9073

21. Gómez-Cano C, Sánchez-Castillo V. Evaluation of the maturity level in project management of a public services company. Económicas CUC 2021;42(2):133-144. https://doi.org/10.17981/econcuc.42.2.2021.Org.7

22. Wong-Parodi G, Mach K, Jagannathan K, Sjostrom K. Insights for developing effective decision support tools for environmental sustainability. Current Opinion in Environmental Sustainability 2020;42:52-59. https://doi.org/10.1016/j.cosust.2020.01.005

23. Lanini I, Samoni S, Husain-Syed F, Fabbri S, Canzani F, Messeri A, et al. Palliative Care for Patients with Kidney Disease. Journal of Clinical Medicine 2022;11(13):3923. https://doi.org/10.3390/jcm11133923

24. Pickering J. Trust, but Verify: Informed Consent, AI Technologies, and Public Health Emergencies. Future Internet 2021;13(5):132. https://doi.org/10.3390/fi13050132

25. Shlobin N, Sheldon M, Lam S. Informed consent in neurosurgery: a systematic review. Neurosurgical Focus 2020;49(5):E6. https://doi.org/10.3171/2020.8.FOCUS20611

26. Mena-Vázquez N, Gomez-Cano C, Perez-Albaladejo L, Manrique-Arija S, Romero-Barco C, Aguilar-Hurtado C, et al. Prospective follow-up of a cohort of patients with interstitial lung disease associated with rheumatoid arthritis in treatment with DMARD. Annals of the Rheumatic Diseases 2018;77(Suppl 2):585. https://doi.org/10.1136/annrheumdis-2018-eular.1935

27. Glaser J, Nouri S, Fernández A, Sudore R, Schillinger D, Klein-Fedyshin M, Schenker Y. Interventions to Improve Patient Comprehension in Informed Consent for Medical and Surgical Procedures: An Updated Systematic Review. Medical Decision Making 2020;40(2):119-143. https://doi.org/10.1177/0272989X19896348

28. Resnik D. Informed Consent, Understanding, and Trust. American Journal of Bioethics 2021;21(5):61-63. https://doi.org/10.1080/15265161.2021.1906987

29. Ulibarri N, Ajibade I, Galappaththi E, Joe E, Lesnikowski A, Mach K, et al. A global assessment of policy tools to support climate adaptation. Climate Policy 2022;22(1):77-96. https://doi.org/10.1080/14693062.2021.2002251

30. Rodríguez-Torres E, Gómez-Cano C, Sánchez-Castillo V. Management information systems and their impact on business decision making. Data and Metadata 2022;1:21. https://doi.org/10.56294/dm202221

31. Sherman K, Kilby C, Pehlivan M, Smith B. Adequacy of measures of informed consent in medical practice: A systematic review. PLoS ONE 2021;16(5):e0251485. https://doi.org/10.1371/journal.pone.0251485

32. Convie L, Carson E, McCusker D, McCain R, McKinley N, Campbell W, et al. The patient and clinician experience of informed consent for surgery: a systematic review of the qualitative evidence. BMC Medical Ethics 2020;21:58. https://doi.org/10.1186/s12910-020-00501-6

33. Algu K. Denied the right to comfort: Racial inequities in palliative care provision. EClinicalMedicine 2021;34:100833. https://doi.org/10.1016/j.eclinm.2021.100833

34. Cloyes K, Candrian C. Palliative and End-of-Life Care for Sexual and Gender Minority Cancer Survivors: a Review of Current Research and Recommendations. Current Oncology Reports 2021;23:146. https://doi.org/10.1007/s11912-021-01034-w

35. Berkman C, Stein G. Experiences of LGBT Patients and Families With Hospice and Palliative Care: Perspectives of the Palliative Care Team. Innovation in Aging 2020;4(Suppl 1):67. https://doi.org/10.1093/geroni/igaa057.218

36. Koffman J, Bajwah S, Davies J, Hussain J. Researching minoritised communities in palliative care: An agenda for change. Palliative Medicine 2022;36(4):530-542. https://doi.org/10.1177/02692163221132091

37. De Panfilis L, Peruselli C, Tanzi S, Botrugno C. AI-based clinical decision-making systems in palliative medicine: ethical challenges. BMJ Supportive & Palliative Care 2023;13(2):183-189. https://doi.org/10.1136/bmjspcare-2021-002948

38. Gajra A, Zettler M, Miller K, Frownfelter J, Showalter J, Valley A, et al. Impact of Augmented Intelligence on Utilization of Palliative Care Services in a Real-World Oncology Setting. JCO Oncology Practice 2022;18(2):e80-e88. https://doi.org/10.1200/OP.21.00179

39. Guzmán DL, Gómez-Cano C, Sánchez-Castillo V. State building through citizen participation. Revista Academia & Derecho 2022;14(25). https://doi.org/10.18041/2215-8944/academia.25.10601

40. Greer J, Moy B, El-Jawahri A, Jackson V, Kamdar M, Jacobsen J, et al. Randomized Trial of a Palliative Care Intervention to Improve End-of-Life Care Discussions in Patients With Metastatic Breast Cancer. Journal of the National Comprehensive Cancer Network 2022;20(2):136-143. https://doi.org/10.6004/jnccn.2021.7040

41. Harasym P, Brisbin S, Afzaal M, Sinnarajah A, Venturato L, Quail P, et al. Barriers and facilitators to optimal supportive end-of-life palliative care in long-term care facilities: a qualitative descriptive study of community-based and specialist palliative care physicians’ experiences, perceptions and perspectives. BMJ Open 2020;10(8):e037466. https://doi.org/10.1136/bmjopen-2020-037466

42. Pérez-Gamboa AJ, Gómez-Cano C, Sánchez-Castillo V. Decision making in university contexts based on knowledge management systems. Data and Metadata 2022;2:92. https://doi.org/10.56294/dm202292

43. Ziegler L, Craigs C, West R, Carder P, Hurlow A, Millares-Martin P, et al. Is palliative care support associated with better quality end-of-life care indicators for patients with advanced cancer? A retrospective cohort study. BMJ Open 2018;8(1):e018284. https://doi.org/10.1136/bmjopen-2017-018284

44. Sleeman K, Timms A, Gillam J, Anderson J, Harding R, Sampson E, Evans C. Priorities and opportunities for palliative and end of life care in United Kingdom health policies: a national documentary analysis. BMC Palliative Care 2021;20:171. https://doi.org/10.1186/s12904-021-00802-6

45. Evans C, Ison L, Ellis-Smith C, Nicholson C, Costa A, Oluyase A, et al. Service Delivery Models to Maximize Quality of Life for Older People at the End of Life: A Rapid Review. Milbank Quarterly 2019;97(1):113-175. https://doi.org/10.1111/1468-0009.12373

46. Parviainen J, Rantala J. Chatbot breakthrough in the 2020s? An ethical reflection on the trend of automated consultations in health care. Medicine, Health Care and Philosophy 2022;25(1):61-71. https://doi.org/10.1007/s11019-021-10049-w

47. Verdicchio M, Perin A. When Doctors and AI Interact: on Human Responsibility for Artificial Risks. Philosophy & Technology 2022;35:11. https://doi.org/10.1007/s13347-022-00506-6

48. Mykhailov D. A moral analysis of intelligent decision-support systems in diagnostics through the lens of Luciano Floridi’s information ethics. Human Affairs 2021;31(2):149-164. https://doi.org/10.1515/humaff-2021-0013

49. Erkal E, Akpınar A, Erkal H. Ethical evaluation of artificial intelligence applications in radiotherapy using the Four Topics Approach. Artificial Intelligence in Medicine 2021;115:102055. https://doi.org/10.1016/J.ARTMED.2021.102055

50. Pérez Gamboa AJ, García Acevedo Y, García Batán J. Life project and university training process: an exploratory study at the University of Camagüey. Transformación 2019;15(3):280-296. http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S2077-29552019000300280

51. Lang B. Are physicians requesting a second opinion really engaging in a reason-giving dialectic? Normative questions on the standards for second opinions and AI. Journal of Medical Ethics 2022;48(4):234-235. https://doi.org/10.1136/medethics-2022-108246

52. Naik N, Hameed B, Shetty D, Swain D, Shah M, Paul R, et al. Legal and Ethical Consideration in Artificial Intelligence in Healthcare: Who Takes Responsibility? Frontiers in Surgery 2022;9:862322. https://doi.org/10.3389/fsurg.2022.862322

53. McDonald J, Graves J, Abrahams N, Thorneycroft R, Hegazi I. Moral judgement development during medical student clinical training. BMC Medical Education 2021;21:585. https://doi.org/10.1186/s12909-021-02572-4

54. De Campos Freitas C, Osório F. Moral judgment and hormones: A systematic literature review. PLoS ONE 2022;17(4):e0265693. https://doi.org/10.1371/journal.pone.0265693

55. Quek C, Ong R, Wong R, Chan S, Chok A, Shen G, et al. Systematic scoping review on moral distress among physicians. BMJ Open 2022;12(8):e064029. https://doi.org/10.1136/bmjopen-2022-064029

FINANCIACIÓN

Ninguna.

CONFLICTO DE INTERESES

Los autores declaran que no existe conflicto de intereses.

CONTRIBUCIÓN DE AUTORÍA

Conceptualización: Ana María Chaves Cano.

Curación de datos: Ana María Chaves Cano.

Análisis formal: Ana María Chaves Cano.

Investigación: Ana María Chaves Cano.

Metodología: Ana María Chaves Cano.

Administración del proyecto: Ana María Chaves Cano.

Recursos: Ana María Chaves Cano.

Software: Ana María Chaves Cano.

Supervisión: Ana María Chaves Cano.

Validación: Ana María Chaves Cano.

Visualización: Ana María Chaves Cano.

Redacción – borrador original: Ana María Chaves Cano.

Redacción – revisión y edición: Ana María Chaves Cano.