REVISIÓN

AI and Climate Justice: Ethical Risks of Predictive Models in Environmental Policies

IA y justicia climática: Riesgos éticos de los modelos predictivos en políticas ambientales

Tulio Andres Clavijo

Gallego1 ![]() *

*

1Universidad del Cauca. Popayan. Colombia.

Citar como: Clavijo Gallego TA. AI and Climate Justice: Ethical Risks of Predictive Models in Environmental Policies. EthAIca. 2023; 2:51. https://doi.org/10.56294/ai202351

Enviado: 17-04-2022 Revisado: 28-08-2022 Aceptado: 22-12-2022 Publicado: 01-01-2023

Editor: PhD.

Rubén González Vallejo ![]()

Autor para la correspondencia: Tulio Andres Clavijo Gallego *

ABSTRACT

The increasing implementation of predictive artificial intelligence (AI) models in environmental policies poses critical challenges for climate justice, particularly concerning equity and the rights of vulnerable communities. This article analyzes the ethical risks associated with the use of AI in environmental decision-making by examining how these systems can perpetuate existing inequalities or generate new forms of exclusion. Through a systematic literature review of articles in Spanish and English indexed in Scopus between 2018 and 2022, four central thematic axes were identified: algorithmic biases and territorial discrimination, opacity in climate governance, displacement of political responsibilities, and exclusion of local knowledge in predictive models. The results reveal that, although AI can optimize the management of natural resources and mitigate climate change, its application without ethical regulation tends to favor actors with greater technological and economic power, marginalizing populations historically affected by the environmental crisis. It is concluded that it is necessary to develop governance frameworks that prioritize algorithmic transparency, community participation, and accountability to ensure that AI-based solutions do not deepen existing climate injustices.

Keywords: Artificial Intelligence; Climate Justice; Algorithmic Biases; Environmental Governance; Public Policies.

RESUMEN

La creciente implementación de modelos predictivos de inteligencia artificial (IA) en políticas ambientales plantea desafíos críticos para la justicia climática, especialmente en lo relativo a la equidad y los derechos de comunidades vulnerables. Este artículo analiza los riesgos éticos asociados con el uso de IA en la toma de decisiones ambientales, al examinar cómo estos sistemas pueden perpetuar desigualdades existentes o generar nuevas formas de exclusión. Mediante una revisión documental sistemática de artículos en español e inglés indexados en Scopus entre 2018 y 2022, se identificaron cuatro ejes temáticos centrales: sesgos algorítmicos y discriminación territorial, opacidad en la gobernanza climática, desplazamiento de responsabilidades políticas, y exclusión de saberes locales en modelos predictivos. Los resultados revelan que, aunque la IA puede optimizar la gestión de recursos naturales y la mitigación del cambio climático, su aplicación sin regulación ética tiende a favorecer a actores con mayor poder tecnológico y económico, lo que margina a poblaciones históricamente afectadas por la crisis ambiental. Se concluye que es necesario desarrollar marcos de gobernanza que prioricen la transparencia algorítmica, la participación comunitaria y la rendición de cuentas, para asegurar que las soluciones basadas en IA no profundicen las injusticias climáticas existentes.

Palabras clave: Inteligencia Artificial; Justicia Climática; Sesgos Algorítmicos; Gobernanza Ambiental; Políticas Públicas.

INTRODUCCIÓN

La crisis climática global ha impulsado a gobiernos y organizaciones a adoptar herramientas tecnológicas avanzadas para diseñar políticas ambientales más efectivas.(1,2) Entre estas, los modelos predictivos de inteligencia artificial (IA) han ganado prominencia por su capacidad para analizar grandes volúmenes de datos climáticos, predecir escenarios futuros y optimizar la asignación de recursos.(3) Sin embargo, esta creciente dependencia de algoritmos plantea interrogantes éticos fundamentales, particularmente en torno a su impacto en la justicia climática.(4,5) Mientras la IA promete soluciones técnicas a problemas complejos, su implementación puede reproducir o incluso exacerbar desigualdades estructurales, lo que afecta desproporcionadamente a comunidades ya vulnerables.(6)

Un aspecto crítico es la forma en que los sesgos intrínsecos en los datos de entrenamiento y el diseño algorítmico pueden distorsionar las prioridades de las políticas ambientales.(7,8) Estudios recientes muestran cómo modelos predictivos utilizados para gestionar recursos hídricos o predecir desastres naturales suelen estar basados en información de regiones desarrolladas, lo que limita su aplicabilidad en contextos con realidades socioecológicas diferentes.(4,9) Esta brecha de representatividad puede llevar a que las intervenciones ambientales ignoren las necesidades de poblaciones marginadas, al profundizar patrones históricos de exclusión.(10) Además, la opacidad de muchos sistemas de IA dificulta evaluar si sus recomendaciones refuerzan dinámicas de poder desiguales.(11)

La justicia climática, como marco ético-político, exige que las soluciones ambientales consideren no solo la eficiencia técnica, sino también la distribución equitativa de sus beneficios y cargas.(12,13) En este sentido, la IA introduce tensiones entre escalabilidad y contextualización, mientras los algoritmos buscan generalizar patrones, las injusticias climáticas son inherentemente locales y específicas.(14,15)

Otro desafío ético radica en la gobernanza de estos sistemas.(16) La creciente privatización de herramientas predictivas por parte de corporaciones tecnológicas concentra el poder de decisión en actores con intereses comerciales, al marginar a comunidades locales en procesos que las afectan directamente.(17) Esta dinámica cuestiona principios democráticos básicos de participación y transparencia, esenciales para políticas ambientales legítimas y efectivas.(2,7) Además, el uso de IA como solucionismo tecnológico puede servir para que gobiernos eludan responsabilidades políticas, al atribuir decisiones complejas a sistemas presentados como neutrales y objetivos.(18)

Existe un riesgo palpable de que los modelos predictivos invisibilicen saberes tradicionales y locales que han demostrado ser cruciales para la adaptación climática en muchas regiones.(19) Al privilegiar datos cuantificables sobre conocimientos ancestrales, estos sistemas pueden erosionar prácticas sostenibles desarrolladas durante generaciones, reemplazándolas con enfoques estandarizados pero culturalmente inapropiados.(13,20)

Este artículo surge ante la urgente necesidad de examinar críticamente cómo la IA ha reconfigurado el campo de las políticas ambientales y sus implicaciones para la justicia climática. Su objetivo es analizar los principales riesgos éticos asociados al uso de modelos predictivos en este ámbito, al identificar tanto los desafíos como las oportunidades para desarrollar marcos de gobernanza más equitativos y participativos. Al hacerlo, busca contribuir al debate sobre cómo aprovechar el potencial de la IA sin sacrificar los principios fundamentales de equidad y justicia ambiental.

MÉTODO

Este estudio se fundamenta en una revisión documental sistemática de la literatura académica sobre la aplicación de modelos predictivos de IA en políticas ambientales y su relación con la justicia climática. Adopta un enfoque cualitativo, la investigación analizó críticamente publicaciones científicas indexadas para identificar patrones, tensiones y vacíos en el debate ético sobre esta problemática emergente.(21,22) El proceso metodológico se estructuró en cinco etapas rigurosas que garantizaron la exhaustividad y validez de los hallazgos.

La primera etapa consistió en la definición de criterios de búsqueda, donde se establecieron ecuaciones booleanas al combinar términos clave como “inteligencia artificial”, “justicia climática”, “ética ambiental” y “políticas públicas”. La búsqueda se limitó a documentos publicados entre 2018-2022 en las bases Scopus y Web of Science, se priorizaron artículos revisados por pares en español e inglés. En la segunda etapa de preselección documental, se aplicaron filtros de relevancia temática mediante el análisis de títulos, resúmenes y palabras clave, se descartaron aquellos trabajos que no abordaban directamente la intersección entre IA y justicia climática.

La tercera etapa implicó un análisis exhaustivo de contenido, donde los documentos seleccionados fueron examinados mediante codificación temática para identificar categorías emergentes. Este proceso permitió organizar la literatura en cuatro ejes analíticos principales que estructuran los resultados. Posteriormente, en la cuarta etapa de triangulación metodológica, se contrastaron las fuentes académicas con informes técnicos de organismos internacionales y casos de estudio relevantes, lo que enriquece el análisis con perspectivas multinivel.

Finalmente, la quinta etapa consistió en la síntesis interpretativa, donde se integraron los hallazgos para construir un marco analítico coherente sobre los riesgos éticos de la IA en políticas ambientales. Este enfoque permitió superar las limitaciones de revisiones tradicionales al incorporar tanto dimensiones técnicas como socio-políticas del problema. La metodología aseguró no solo identificar tendencias en la literatura, sino también revelar contradicciones y vacíos críticos en este campo de estudio emergente.

RESULTADOS

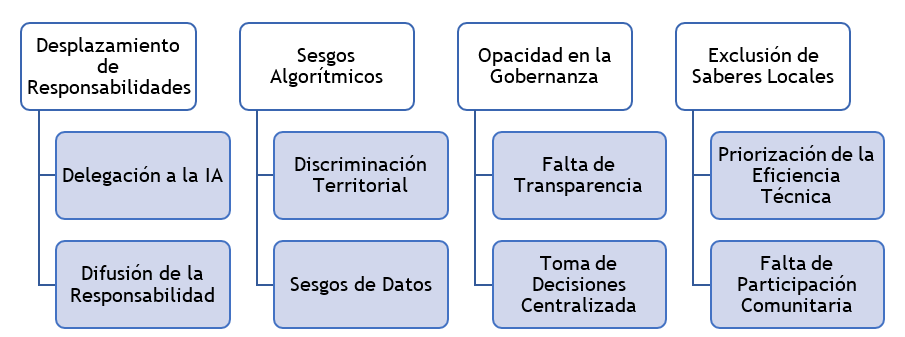

Una revisión crítica de la literatura permitió identificar que la implementación de modelos predictivos de IA en políticas ambientales no es un proceso neutral, sino que reproduce y amplifica dinámicas de inequidad socioecológica. Los estudios analizados evidencian que, pese a su potencial para optimizar la gestión de recursos naturales, estos sistemas suelen operar bajo lógicas tecnocráticas que marginan a comunidades vulnerables y priorizan intereses económicos o geopolíticos. A partir de este diagnóstico, emergieron cuatro ejes temáticos centrales que estructuran los riesgos éticos identificados: sesgos algorítmicos y discriminación territorial, opacidad en la gobernanza climática, desplazamiento de responsabilidades políticas y exclusión de saberes locales. Estos ejes reflejan tensiones entre el paradigma de eficiencia técnica dominante en la IA y los principios de justicia climática, que exigen equidad, transparencia y participación en la toma de decisiones ambientales (ver figura 1).

Figura 1. Riesgos éticos en IA para políticas ambientales

Sesgos algorítmicos y discriminación territorial

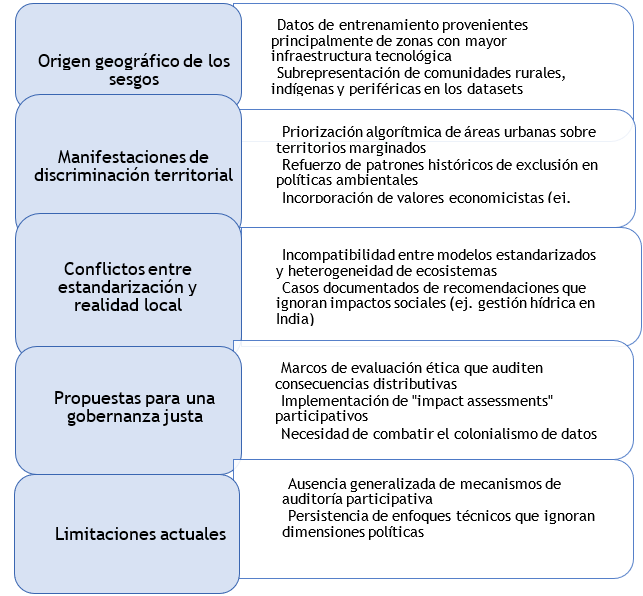

La literatura revisada destaca que los modelos predictivos de IA utilizados en políticas ambientales están frecuentemente sesgados hacia realidades geográficas y socioeconómicas específicas, lo que genera discriminación territorial sistémica (ver figura 2).(23,24) Estos sesgos se originan en la selección de datos de entrenamiento, que suelen provenir de regiones con mayor infraestructura tecnológica, lo que deja fuera a comunidades rurales, indígenas o periféricas.(25)

Como resultado, las recomendaciones algorítmicas refuerzan patrones históricos de exclusión, como priorizar la protección de áreas urbanas sobre territorios marginados con menor representación en los datasets.(26)Este fenómeno no es técnico, sino político, los criterios de “eficiencia” incorporados en los modelos suelen reflejar valores economicistas, como maximizar el PIB o proteger infraestructura costosa, en detrimento de medios de vida locales.(27)

Además, la estandarización de los algoritmos choca con la heterogeneidad de los ecosistemas y las necesidades comunitarias.(17,28) Investigaciones en India mostraron cómo sistemas de IA para gestión hídrica recomendaban represas en zonas ya afectadas por desplazamientos forzados, al basarse en métricas hidrológicas sin considerar impactos sociales.(29)

La justicia climática exige abordar estos sesgos mediante marcos de evaluación ética que auditen no solo la precisión técnica, sino también las consecuencias distributivas de los modelos.(30) Propuestas como los “impact assessments” participativos buscan identificar qué grupos quedan invisibilizados en los datos y cómo las salidas algorítmicas redistribuyen riesgos ambientales.(18,31) Sin embargo, la mayoría de las políticas actuales carecen de estos mecanismos, lo que perpetua lo que se ha denominado colonialismo de datos en la gobernanza climática.(32)

Figura 2. Consecuencias y limitaciones asociados a los sesgos algorítmicos

Opacidad en la gobernanza climática

El segundo eje analítico revela que la opacidad de los sistemas de IA utilizados en políticas ambientales socava la rendición de cuentas y la participación democrática.(33) Según los documentos revisados, esta opacidad opera en tres niveles: el secreto corporativo alrededor de algoritmos patentados por empresas tecnológicas, la complejidad técnica que impide su escrutinio público, y la falta de voluntad política para transparentar criterios de decisión.(34) En la práctica, esto convierte a los modelos predictivos en “cajas negras” que legitiman decisiones sin permitir su cuestionamiento.(13)

La literatura señala que esta opacidad beneficia a actores con poder tecnológico y económico, ya que pueden influir en el diseño de los sistemas sin asumir responsabilidad por sus impactos.(34,35) Por el contrario, comunidades afectadas quedan en desventaja para impugnar decisiones.(22,35) Esto agrava asimetrías históricas, mientras corporaciones y gobiernos centralizados controlan la infraestructura de IA, las demandas locales por transparencia son criminalizadas o ignoradas.(14,24)

Frente a esto, surgen propuestas como el derecho a la explicación en regulaciones europeas (GDPR) o estándares de “IA auditable” promovidos por la ONU.(36) No obstante, su implementación es incipiente y enfrenta resistencias de lobbies tecnológicos.(15,28) La justicia climática, en este contexto, requiere no solo abrir los algoritmos, sino también democratizar su gobernanza mediante la inclusión de actores tradicionalmente excluidos de estos procesos.

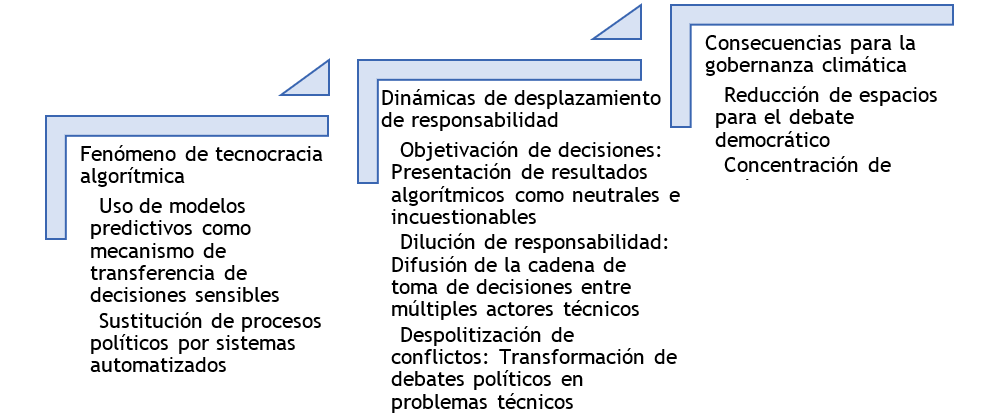

Desplazamiento de responsabilidades políticas

El análisis reveló un fenómeno creciente de tecnocracia algorítmica en la gobernanza climática, donde los modelos predictivos de IA se utilizan como mecanismo para transferir decisiones políticamente sensibles desde actores humanos a sistemas automatizados (ver figura 3).(37) Este desplazamiento opera mediante tres dinámicas interrelacionadas: la objetivación de decisiones, la dilución de responsabilidad y la despolitización de conflictos.(38,39)

Figura 3. Causas y consecuencias del desplazamiento de responsabilidades políticas

Un ejemplo paradigmático se encontró en el sistema holandés de gestión de inundaciones, donde algoritmos determinaban prioridades de protección territorial basándose únicamente en criterios económicos, al ignorar consideraciones de equidad interregional.(40) Cuando comunidades rurales protestaron por el sesgo urbano de las decisiones, las autoridades alegaron que simplemente “seguían los datos”. La literatura identificó este patrón como “autoridad algorítmica”, la tendencia a aceptar resultados de IA como superiores al juicio humano en contextos de incertidumbre climática.(41)

Este fenómeno plantea graves riesgos para la justicia climática al reducir espacios de debate democrático sobre alternativas políticas, concentrar poder en actores con acceso a tecnología avanzada, y crear nuevos tipos de vulnerabilidad para comunidades sin capacidad de auditar o cuestionar modelos predictivos.(18,42) Investigaciones en Australia mostraron cómo sistemas de IA para asignar recursos post-desastres reproducían patrones coloniales de exclusión, pero los funcionarios evitaban responsabilizarse al alegar limitaciones técnicas del sistema.(43)

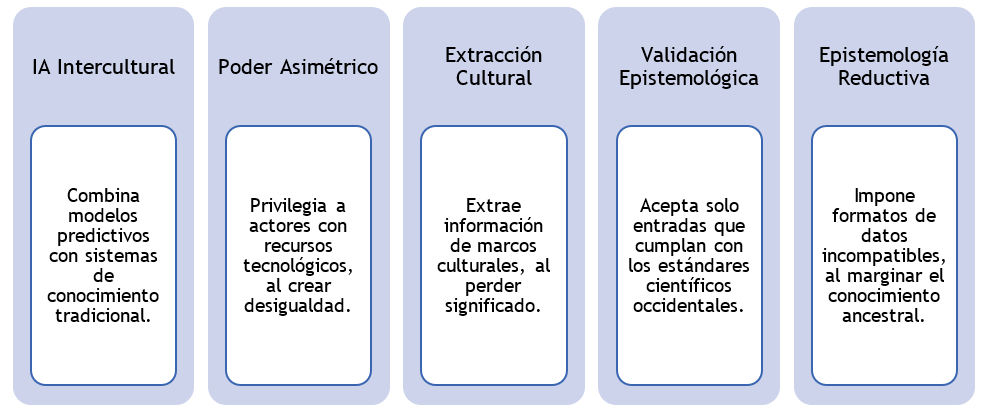

Exclusión de saberes locales y epistemologías alternativas

Los modelos predictivos predominantes en políticas ambientales se basan en una epistemología reduccionista que margina sistemáticamente formas de conocimiento no cuantificables.(44) La revisión documental encontró que los sistemas analizados no incorporaban mecanismos para integrar saberes tradicionales o comunitarios sobre gestión ecosistémica.(3,9,14,31) Esta exclusión opera mediante cuatro mecanismos: estandarización, validación epistemológica, descontextualización (ver figura 4).

Casos documentados en la Amazonía demostraron cómo algoritmos para monitoreo forestal ignoraban sistemas indígenas de clasificación ecológica, que identificaban patrones de degradación invisibles para sensores satelitales.(45) En Kenia, pastores masai fueron excluidos de sistemas predictivos de sequías porque sus conocimientos no podían traducirse a los formatos de datos requeridos por los algoritmos.(46)

Esta exclusión tiene consecuencias prácticas graves: reduce la efectividad de políticas al ignorar conocimientos probados localmente, erosiona derechos culturales de pueblos originarios, y reproduce colonialismos epistemológicos en la gobernanza ambiental.(9,41) La literatura reveló esfuerzos emergentes para desarrollar “IA intercultural” que combine modelos predictivos con sistemas de conocimiento tradicional.(22,28) Sin embargo, estos casos son excepcionales frente al predominio de enfoques tecnocéntricos.

Figura 4. Modelos predictivos de políticas ambientales

DISCUSIÓN

Los hallazgos revelan que la implementación de modelos predictivos en políticas climáticas no opera en un vacío ético, sino que reproduce y amplifica dinámicas de poder preexistentes. La supuesta neutralidad técnica de estos sistemas frecuentemente enmascara decisiones valorativas que priorizan ciertos intereses sobre otros, particularmente cuando los datos de entrenamiento reflejan sesgos históricos o geopolíticos.(47) Esto plantea un desafío fundamental, especialmente cuando afectan a comunidades ya marginadas en contextos de vulnerabilidad climática.(38,40)

Un hallazgo preocupante es la forma en que estos sistemas pueden erosionar los procesos democráticos en la gobernanza ambiental.(48) Al transferir autoridad decisoria a algoritmos opacos, se reducen los espacios para el debate público sobre alternativas políticas y la rendición de cuentas.(35,39) Esto es particularmente grave cuando las poblaciones afectadas no tienen capacidad técnica o institucional para auditar los modelos que determinan el acceso a recursos críticos o la distribución de riesgos ambientales, al crear nuevas formas de exclusión política bajo estructuras tecnocráticas.(42)

La investigación también evidencia una tensión epistemológica profunda entre los conocimientos científicos-técnicos incorporados en los algoritmos y los saberes locales sobre gestión ecosistémica.(9,18) Esta brecha no es meramente metodológica, sino que refleja relaciones de poder asimétricas que invalidan formas de conocimiento no occidentales.(49) Los resultados sugieren que la efectividad misma de las políticas climáticas se ve comprometida cuando se ignoran sistemas de comprensión y adaptación ambiental desarrollados durante siglos por comunidades indígenas y locales.(24)

Finalmente, el estudio destaca la paradoja central de confiar en soluciones tecnológicas estandarizadas para abordar crisis ambientales que son, por naturaleza, profundamente contextuales y desiguales.(44,46) Mientras la IA puede ofrecer herramientas valiosas para el análisis climático, su implementación requiere marcos éticos que prioricen la equidad sobre la eficiencia, la participación sobre la automatización, y la diversidad epistémica sobre el universalismo tecnológico.(50,51) Esto exige no solo mejorar los sistemas técnicos, sino transformar las estructuras de gobernanza que determinan cómo, por quién y para qué se usan estas tecnologías.

CONCLUSIONES

Este estudio evidencia que la implementación de modelos predictivos de IA en políticas ambientales requiere un enfoque crítico que trascienda el optimismo tecnológico dominante. Los hallazgos demuestran que estos sistemas, lejos de ser neutrales, reproducen y amplifican desigualdades estructurales cuando no están acompañados de salvaguardas éticas robustas. Se concluye que el desafío fundamental radica en desarrollar marcos de gobernanza que prioricen la justicia climática sobre la eficiencia técnica, al garantizar transparencia algorítmica, participación comunitaria efectiva y reconocimiento de saberes locales.

La investigación subraya la urgencia de reorientar el desarrollo tecnológico hacia modelos de IA interculturales y auditables, que complementen -no reemplacen- los procesos democráticos en la toma de decisiones ambientales. Esto exige no solo mejoras técnicas en los sistemas predictivos, sino transformaciones profundas en las estructuras de poder que determinan su diseño e implementación, al asegurar que la innovación tecnológica sirva realmente a la equidad socioambiental.

REFERENCIAS

1. Wong-Parodi G, Mach K, Jagannathan K, Sjostrom K. Insights for developing effective decision support tools for environmental sustainability. Current Opinion in Environmental Sustainability 2020;42:52-59. https://doi.org/10.1016/j.cosust.2020.01.005

2. Ulibarri N, Ajibade I, Galappaththi E, Joe E, Lesnikowski A, Mach K, et al. A global assessment of policy tools to support climate adaptation. Climate Policy 2022;22(1):77-96. https://doi.org/10.1080/14693062.2021.2002251

3. Pérez Gamboa AJ, García Acevedo Y, García Batán J. Life project and university training process: an exploratory study at the University of Camagüey. Transformación 2019;15(3):280-296. http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S2077-29552019000300280

4. Shen C, Li S, Wang X, Liao Z. The effect of environmental policy tools on regional green innovation: Evidence from China. Journal of Cleaner Production 2020;254:120122. https://doi.org/10.1016/j.jclepro.2020.120122

5. Ji X, Wu G, Lin J, Zhang J, Su P. Reconsider policy allocation strategies: A review of environmental policy instruments and application of the CGE model. Journal of Environmental Management 2022;323:116176. https://doi.org/10.1016/j.jenvman.2022.116176

6. Dudkowiak A, Grajewski D, Dostatni E. Analysis of Selected IT Tools Supporting Eco-Design in the 3D CAD Environment. IEEE Access 2021;9:134945-134956. https://doi.org/10.1109/ACCESS.2021.3116469

7. Gómez-Monroy CA, Cuesta-Ramírez DH, Gómez-Cano CA. Analysis of the perception of tax on the consumption of plastic bags charged in large and medium-sized establishments from the center of Florence. LOGINN Investigación Científica y Tecnológica 2021;5(1). https://dx.doi.org/10.23850/25907441.4320

8. Wu T, Chin K, Lai Y. Applications of Intelligent Environmental IoT Detection Tools in Environmental Education of College Students. 2022 12th International Congress on Advanced Applied Informatics (IIAI-AAI) 2022:240-243. https://doi.org/10.1109/iiaiaai55812.2022.00055

9. Malik A, Tikhamarine Y, Sammen S, Abba S, Shahid S. Prediction of meteorological drought by using hybrid support vector regression optimized with HHO versus PSO algorithms. Environmental Science and Pollution Research 2021;28:39139-39158. https://doi.org/10.1007/s11356-021-13445-0

10. Brunner M, Slater L, Tallaksen L, Clark M. Challenges in modeling and predicting floods and droughts: A review. Wiley Interdisciplinary Reviews: Water 2021;8(3):e1520. https://doi.org/10.1002/wat2.1520

11. Pérez-Gamboa AJ, Gómez-Cano C, Sánchez-Castillo V. Decision making in university contexts based on knowledge management systems. Data and Metadata 2022;2:92. https://doi.org/10.56294/dm202292

12. Anshuka A, Van Ogtrop F, Vervoort W. Drought forecasting through statistical models using standardised precipitation index: a systematic review and meta-regression analysis. Natural Hazards 2019;97:955-977. https://doi.org/10.1007/s11069-019-03665-6

13. Dikshit A, Pradhan B. Interpretable and explainable AI (XAI) model for spatial drought prediction. Science of the Total Environment 2021;801:149797. https://doi.org/10.1016/j.scitotenv.2021.149797

14. Zhang R, Chen Z, Xu L, Ou C. Meteorological drought forecasting based on a statistical model with machine learning techniques in Shaanxi province, China. Science of the Total Environment 2019;665:338-346. https://doi.org/10.1016/j.scitotenv.2019.01.431

15. McGovern A, Ebert-Uphoff I, Gagne D, Bostrom A. Why we need to focus on developing ethical, responsible, and trustworthy artificial intelligence approaches for environmental science. Environmental Data Science 2022;1:e5. https://doi.org/10.1017/eds.2022.5

16. Gómez Cano CM, Valencia Arias JA. Mechanisms used to measure technological innovation capabilities in organizations: results from a bibliometric analysis. Revista Guillermo de Ockham 2020;18(1):69-79. https://doi.org/10.21500/22563202.4550

17. Coeckelbergh M. AI for climate: freedom, justice, and other ethical and political challenges. AI and Ethics 2020;1:67-72. https://doi.org/10.1007/s43681-020-00007-2

18. Osipov V, Skryl T. AI’s contribution to combating climate change and achieving environmental justice in the global economy. Frontiers in Environmental Science 2022;10:952695. https://doi.org/10.3389/fenvs.2022.952695

19. Byskov M, Hyams K. Epistemic injustice in Climate Adaptation. Ethical Theory and Moral Practice 2022;25:613-634. https://doi.org/10.1007/s10677-022-10301-z

20. Rodríguez-Torres E, Gómez-Cano C, Sánchez-Castillo V. Management information systems and their impact on business decision making. Data and Metadata 2022;1:21. https://doi.org/10.56294/dm202221

21. Verlie B. Climate justice in more-than-human worlds. Environmental Politics 2022;31(2):297-319. https://doi.org/10.1080/09644016.2021.1981081

22. Cowls J, Tsamados A, Taddeo M, Floridi L. The AI gambit: leveraging artificial intelligence to combat climate change—opportunities, challenges, and recommendations. AI & Society 2023;38:283-307. https://doi.org/10.1007/s00146-021-01294-x

23. Sardo M. Responsibility for climate justice: Political not moral. European Journal of Political Theory 2023;22(1):26-50. https://doi.org/10.1177/1474885120955148

24. Gómez-Cano C, Sánchez V, Tovar G. Endogenous factors causing irregular permanence: a reading from teaching practice. Educación y Humanismo 2018;20(35):96-112. http://dx.10.17081/eduhum.20.35.3030

25. Porter L, Rickards L, Verlie B, Bosomworth K, Moloney S, Lay B, et al. Climate Justice in a Climate Changed World. Planning Theory & Practice 2020;21(2):293-321. https://doi.org/10.1080/14649357.2020.1748959

26. Cho J, Ahmed S, Hilbert M, Liu B, Luu J. Do Search Algorithms Endanger Democracy? An Experimental Investigation of Algorithm Effects on Political Polarization. Journal of Broadcasting & Electronic Media 2020;64(2):150-172. https://doi.org/10.1080/08838151.2020.1757365

27. Boratto L, Marras M, Faralli S, Stilo G. International Workshop on Algorithmic Bias in Search and Recommendation (Bias 2020). In: Advances in Information Retrieval. Lecture Notes in Computer Science 2020;12036:637-640. https://doi.org/10.1007/978-3-030-45442-5_84

28. Gómez-Cano C, Sánchez-Castillo V. Evaluation of the maturity level in project management of a public services company. Económicas CUC 2021;42(2):133-144. https://doi.org/10.17981/econcuc.42.2.2021.Org.7

29. Zhang M, Wu S, Yu X, Wang L. Dynamic Graph Neural Networks for Sequential Recommendation. IEEE Transactions on Knowledge and Data Engineering 2023;35(5):4741-4753. https://doi.org/10.1109/TKDE.2022.3151618

30. Di W, Wu Z, Lin Y. TRR: Target-relation regulated network for sequential recommendation. PLoS ONE 2022;17(5):e0269651. https://doi.org/10.1371/journal.pone.0269651

31. Liu F, Tang R, Li X, Zhang W, Ye Y, Chen H, et al. State representation modeling for deep reinforcement learning based recommendation. Knowledge-Based Systems 2020;205:106170. https://doi.org/10.1016/j.knosys.2020.106170

32. Zhang Y, Yin G, Dong H, Zhang L. Attention-based Frequency-aware Multi-scale Network for Sequential Recommendation. Applied Soft Computing 2022;127:109349. https://doi.org/10.1016/j.asoc.2022.109349

33. Guzmán DL, Gómez-Cano C, Sánchez-Castillo V. State building through citizen participation. Revista Academia & Derecho 2022;14(25). https://doi.org/10.18041/2215-8944/academia.25.10601

34. Wellmann T, Lausch A, Andersson E, Knapp S, Cortinovis C, Jache J, et al. Remote sensing in urban planning: Contributions towards ecologically sound policies? Landscape and Urban Planning 2020;204:103921. https://doi.org/10.1016/j.landurbplan.2020.103921

35. Bacon A, Russell J. The Logic of Opacity. Philosophy and Phenomenological Research 2019;99(1):81-114. https://doi.org/10.1111/PHPR.12454

36. Sánchez Castillo V, Gómez Cano CA, Millán Rojas EE. Dynamics of operation and challenges of the peasant market Coopmercasan of Florencia (Caquetá). Investigación y Desarrollo 2020;28(2):22-56. https://doi.org/10.14482/indes.28.2.330.122

37. Zheng Y. Does bank opacity affect lending? Journal of Banking and Finance 2020;119:105900. https://doi.org/10.1016/j.jbankfin.2020.105900

38. Chin C. Business Strategy and Financial Opacity. Emerging Markets Finance and Trade 2023;59(7):1818-1834. https://doi.org/10.1080/1540496X.2022.2147779

39. Yin X, Zamani M, Liu S. On Approximate Opacity of Cyber-Physical Systems. IEEE Transactions on Automatic Control 2021;66(4):1630-1645. https://doi.org/10.1109/TAC.2020.2998733

40. Guo Y, Jiang X, Guo C, Wang S, Karoui O. Overview of Opacity in Discrete Event Systems. IEEE Access 2020;8:48731-48741. https://doi.org/10.1109/ACCESS.2020.2977992

41. Tovar-Cardozo G, Sánchez-Castillo V, Gómez-Cano CA. Tourism as an economic alternative in the municipality of Belén de los Andaquíes (Caquetá). Revista Criterios 2020;27(1):173-188. https://doi.org/10.31948/rev.criterios/27.1-art8

42. Hélouët L, Marchand H, Ricker L. Opacity with powerful attackers. IFAC-PapersOnLine 2018;51(7):464-471. https://doi.org/10.1016/J.IFACOL.2018.06.341

43. Koo K, Kim J. CEO power and firm opacity. Applied Economics Letters 2019;26(10):791-794. https://doi.org/10.1080/13504851.2018.1497841

44. Maurer M, Bogner F. Modelling environmental literacy with environmental knowledge, values and (reported) behaviour. Studies in Educational Evaluation 2020;65:100863. https://doi.org/10.1016/j.stueduc.2020.100863

45. Bind M. Causal Modeling in Environmental Health. Annual Review of Public Health 2019;40:23-43. https://doi.org/10.1146/annurev-publhealth-040218-044048

46. Wood K, Stillman R, Hilton G. Conservation in a changing world needs predictive models. Animal Conservation 2018;21(2):87-88. https://doi.org/10.1111/acv.12371

47. Cahan E, Hernandez-Boussard T, Thadaney-Israni S, Rubin D. Putting the data before the algorithm in big data addressing personalized healthcare. NPJ Digital Medicine 2019;2:78. https://doi.org/10.1038/s41746-019-0157-2

48. Urban C, Christakis M, Wüstholz V, Zhang F. Perfectly parallel fairness certification of neural networks. Proceedings of the ACM on Programming Languages 2020;4(OOPSLA):1-30. https://doi.org/10.1145/3428253

49. Wong P. Democratizing Algorithmic Fairness. Philosophy & Technology 2020;33(2):225-244. https://doi.org/10.1007/s13347-019-00355-w

50. Guayara Cuéllar CT, Millán Rojas EE, Gómez Cano CA. Design of a virtual digital literacy course for teachers at the University of Amazonia. Revista Científica 2019;(34):34-48. https://doi.org/10.14483/23448350.13314

51. Uygur O. CEO ability and corporate opacity. Global Finance Journal 2018;35:72-81. https://doi.org/10.1016/J.GFJ.2017.05.002

FINANCIACIÓN

Ninguna.

CONFLICTO DE INTERESES

Ninguno.

CONTRIBUCIÓN DE AUTORÍA

Conceptualización: Tulio Andres Clavijo Gallego.

Curación de datos: Tulio Andres Clavijo Gallego.

Análisis formal: Tulio Andres Clavijo Gallego.

Adquisición de fondos: Tulio Andres Clavijo Gallego.

Investigación: Tulio Andres Clavijo Gallego.

Metodología: Tulio Andres Clavijo Gallego.

Administración del proyecto: Tulio Andres Clavijo Gallego.

Recursos: Tulio Andres Clavijo Gallego.

Software: Tulio Andres Clavijo Gallego.

Supervisión: Tulio Andres Clavijo Gallego.

Validación: Tulio Andres Clavijo Gallego.

Visualización: Tulio Andres Clavijo Gallego.

Redacción – borrador original: Tulio Andres Clavijo Gallego.

Redacción – revisión y edición: Tulio Andres Clavijo Gallego.